Confidencial Noticias

Por: Juan Luis Castro

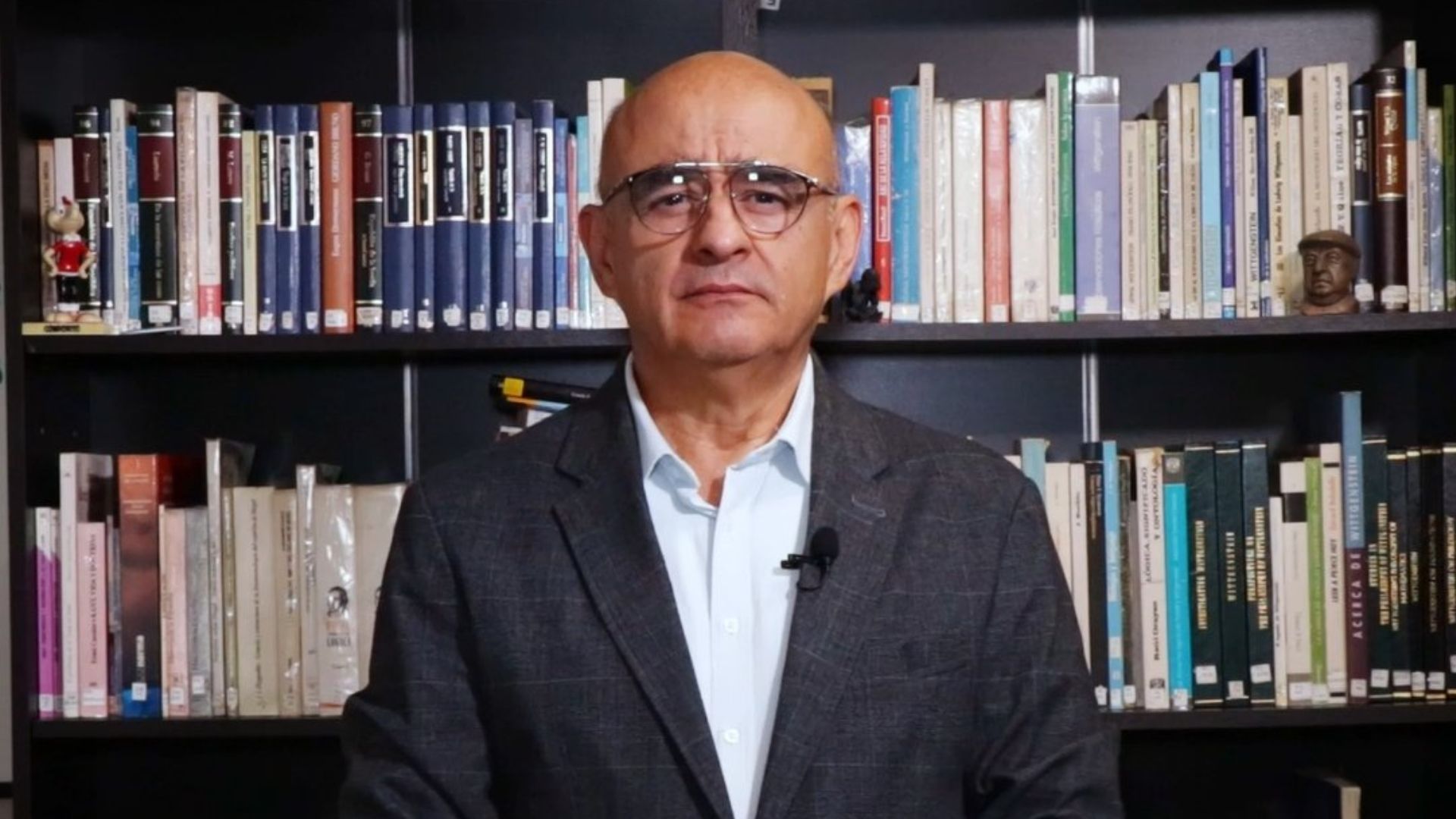

El 24 de mayo, José Fernando Angulo, un hombre negro cabeza de familia, paciente esperaba la llegada del bus que lo lleva a su casa. Pese a las recomendaciones de acogerse al aislamiento preventivo, José salió de su hogar para atender sus responsabilidades y lo hizo sin el tapabocas que absolutamente todos deberíamos tener.

El 24 de mayo, José Fernando Angulo, un hombre negro cabeza de familia, paciente esperaba la llegada del bus que lo lleva a su casa. Pese a las recomendaciones de acogerse al aislamiento preventivo, José salió de su hogar para atender sus responsabilidades y lo hizo sin el tapabocas que absolutamente todos deberíamos tener.

Mientras José esperaba en la estación del Mío, un patrullero de la policía le pidió que saliera del sistema de transporte dado que el no uso del tapabocas no solo ponía en riesgo su salud, también la de los demás miembros de la comunidad ante un hipotético contagio de coronavirus. José se rehusó.

Según cuenta su hija en la denuncia que hizo públicamente, la respuesta negativa ante la petición del patrullero le ocasionó a José ser objeto de la acción policial violenta. Por no portar su tapabocas, las tonfas de varios patrulleros mandaron a José para su casa con algo más que raspones y moretones. Esta no es la manera.

Tras haber soportado el ataque de la policía, un fuerte dolor abdominal causado, según el dictamen de la Clínica Amiga en Cali, por la perforación de su intestino delgado, José permaneció en cuidados intensivos durante poco más de 15 días.

Cándida y apresurada conclusión de mis lectores sería pensar que la lección de este testimonio es usar el tapabocas para que “la policía no le casque”. La historia de José recoge el manejo equivocado que se le ha dado tanto a la crisis económica como a la crisis de salud pública y que con el que no se debería continuar. A continuación, se los explico:

Partamos del hecho de que el periodo inicial de cuarentena se desperdició pues no se activaron estrategias que disminuyeran el nivel de riesgo al volver a las calles, lo que se activó fue el flujo de personas en las calles. Apenas lógico que José fuera una más de ellas.

Desde el día 1 muchos hemos insistido en que una de las estrategias más beneficias en el combate contra la pandemia es la distribución masiva de tapabocas: para disminuir la tasa de propagación del virus y para que ante el escenario inminente en que José y muchos otros retornarán al espacio público el nivel de riesgo fuera al menos 40% menor.

Al sol de hoy no hay una política nacional y pública de distribución masiva de tapabocas, por lo que colombianos y colombianas que ya han retomado sus actividades posiblemente no tengan un tapabocas. Invito a los gobiernos locales a desplegar su alcance en este sentido y no subestimar los estragos que nos puede ocasionar la reapertura económica.

Ahora bien, es totalmente claro que es un error no haber distribuido tapabocas y que por ende haya personas circulando sin él, no obstante, nada justifica que la lógica de las autoridades siempre se tumbe hacia la corrección del error desde la tonfa o “bolillo” que reparten como si estuviera en promoción.

José Fernando fue enviado a una UCI, de las tan necesarias por estos días, por un desfazado y francamente absurdo abuso de autoridad. Eso sin mencionar la repercusión que este hecho tuvo sobre su familia y la comunidad.

¿Por qué motivos la policía reprende con brutal fuerza a los ciudadanos? ¿Cuáles son los elementos de juicio de los uniformados al administrar la fuerza? Algo está desencajado.

Estoy convencido de que casos como el de José Fernando Angulo, el de Anderson Arboleda y el de Janner García no son episodios aislados. Urge que la Policía y los entes de control investiguen y juzguen este comportamiento atroz por parte de los uniformados. No es admisible que el conteo de estos ataques siga creciendo, TODA VIDA ES SAGRADA.

Para finalizar, invito a los lectores a seguir acogiendo las medidas de aislamiento preventivo y de tener que salir a la calle háganlo siempre con tapabocas. Estamos próximos al pico de los contagios y la cooperación es clave.

#LasVidasNegrasImportan

Más columnas del autor

PORTADA

Consejo Superior de la Universidad Nacional posesiona a José Ismael Peña en la rectoría

Juan Manuel Galán recibe apoyo de un grupo de exministros y excongresistas

Niegan principio de oportunidad a Carlos Mattos por salir de la prisión a pasear por Bogotá

Pacto Histórico anuncia la creación de una plataforma electoral paralela a la del CNE