La inteligencia artificial (IA) se ha convertido en una herramienta poderosa en el campo de la medicina, ayudando a diagnosticar enfermedades, predecir resultados clínicos y personalizar tratamientos. Sin embargo, a medida que aumenta su presencia en los procesos clínicos, también aumenta la preocupación por su opacidad. Muchos de los sistemas actuales funcionan como cajas negras: ofrecen recomendaciones o diagnósticos sin explicar cómo llegaron a estas conclusiones. En un entorno donde las decisiones pueden afectar directamente la vida de los pacientes, comprender y confiar en los sistemas automatizados es fundamental. Junto con el equipo de jugabet app, analizamos más de cerca cómo la llamada inteligencia artificial explicable (o XAI) está intentando resolver estos problemas.

Qué es la inteligencia artificial explicable y cómo se diferencia de otros modelos

La inteligencia artificial explicable (XAI) se refiere a un conjunto de métodos y procesos que permiten que los resultados generados por modelos de IA sean comprensibles para los seres humanos. A diferencia de los algoritmos opacos —como muchas redes neuronales profundas— que producen resultados difíciles de interpretar, los sistemas XAI están diseñados para ofrecer razones claras detrás de cada predicción o decisión. Esto no significa que los modelos simples sean necesariamente mejores, sino que se busca un equilibrio entre precisión y transparencia.

En el ámbito médico, esta diferenciación es fundamental. No basta con que un modelo prediga correctamente la presencia de una enfermedad; los profesionales necesitan saber por qué ha llegado a esa conclusión. Por ejemplo, un sistema que detecta cáncer en imágenes radiológicas debe señalar qué patrones visuales o características específicas han llevado a esa predicción. La XAI hace posible que los médicos evalúen críticamente las recomendaciones de la IA, complementando su propio juicio clínico y evitando una dependencia ciega en la tecnología. Este tipo de enfoque también es esencial para cumplir con normativas legales que exigen trazabilidad y responsabilidad en las decisiones médicas asistidas por algoritmos.

Cómo los algoritmos generan explicaciones: técnicas y enfoques actuales

Para lograr que un sistema de IA sea explicable, se utilizan diversas técnicas que varían según el tipo de modelo y el contexto de aplicación. Una de las aproximaciones más comunes es la creación de modelos interpretables por diseño, como los árboles de decisión o los modelos lineales, que permiten visualizar de manera directa cómo los datos de entrada afectan a la salida. Otra opción es aplicar técnicas de post-hoc, como LIME o SHAP, que generan explicaciones sobre modelos complejos ya entrenados, señalando qué variables han influido más en una predicción específica.

En el campo de la medicina, estas explicaciones deben ser especialmente claras y relevantes. No basta con identificar correlaciones estadísticas; los profesionales necesitan ver relaciones clínicamente significativas. Por ejemplo, si un algoritmo sugiere que un paciente tiene alto riesgo de insuficiencia cardíaca, debe poder mostrar que esto se debe, entre otros factores, a niveles específicos de biomarcadores, antecedentes médicos y datos de estilo de vida. El reto está en traducir estructuras matemáticas abstractas en información útil y comprensible, sin perder la riqueza predictiva que ofrecen los modelos complejos. La investigación en XAI continúa evolucionando para lograr este delicado equilibrio.

Aplicaciones prácticas del XAI en el ámbito médico

La inteligencia artificial explicable ya está siendo implementada en diversas áreas de la medicina, aportando claridad en situaciones clínicas complejas. En el diagnóstico por imagen, por ejemplo, sistemas basados en aprendizaje profundo pueden detectar lesiones pulmonares o cerebrales y luego señalar en la imagen los puntos exactos que motivaron esa detección. De este modo, los radiólogos no solo reciben un resultado, sino también una justificación visual que les permite validar o cuestionar la predicción.

Otro ámbito donde XAI ha demostrado ser útil es la medicina personalizada. Algoritmos que analizan datos genéticos o históricos clínicos pueden recomendar tratamientos específicos para cada paciente, explicando qué variantes genéticas o síntomas han influido en esa elección. Esta transparencia es esencial para que los médicos discutan con los pacientes las opciones disponibles, fortaleciendo el consentimiento informado. También se ha aplicado XAI en sistemas de triaje en urgencias y en la predicción de complicaciones postoperatorias, donde la rapidez y la comprensión de los factores de riesgo son vitales. Estas aplicaciones no solo mejoran la calidad del diagnóstico y tratamiento, sino también la confianza en el uso de tecnología en medicina.

Retos y limitaciones de la inteligencia artificial explicable en medicina

A pesar de sus promesas, la inteligencia artificial explicable enfrenta múltiples desafíos en su implementación dentro del sistema de salud. Uno de los principales es la complejidad inherente de muchos modelos de aprendizaje profundo. Cuanto más precisos son, más difíciles suelen ser de interpretar, y esto genera un conflicto entre precisión y transparencia. Además, no todas las explicaciones generadas por XAI son igualmente útiles: algunas pueden ser demasiado técnicas para los médicos generales o demasiado vagas para orientar decisiones clínicas concretas.

Otro obstáculo importante es la falta de estándares sobre qué constituye una buena explicación en el contexto médico. ¿Debe una explicación ser estadísticamente válida, clínicamente relevante o emocionalmente tranquilizadora? La respuesta varía según el caso y los usuarios. Además, existe el riesgo de que las explicaciones generadas den una falsa sensación de comprensión o confianza, llevando a decisiones equivocadas. También hay limitaciones prácticas como la necesidad de tiempo, recursos computacionales y formación adecuada para que los profesionales puedan interpretar correctamente los resultados del XAI. Todos estos factores deben ser cuidadosamente considerados al integrar estas tecnologías en los sistemas sanitarios.

Implicaciones éticas y sociales: confianza, responsabilidad y equidad

El desarrollo de sistemas de inteligencia artificial explicable en medicina no solo es un reto técnico, sino también ético. La capacidad de explicar decisiones algorítmicas está estrechamente ligada a la confianza del público. Si los pacientes y médicos pueden entender por qué se tomó una determinada decisión, es más probable que acepten y cooperen con los resultados del sistema. Por el contrario, una IA opaca puede generar desconfianza, especialmente en poblaciones vulnerables o históricamente marginadas por el sistema de salud.

Además, la explicabilidad está relacionada con la responsabilidad legal y moral. En caso de error o daño, es fundamental poder rastrear cómo y por qué se llegó a una recomendación médica. La XAI permite este tipo de auditoría, haciendo que las decisiones sean más transparentes y justas. También abre la puerta a detectar posibles sesgos en los datos o en el diseño del algoritmo, lo cual es crucial para garantizar la equidad. Por ejemplo, si un sistema sistemáticamente subestima el riesgo en pacientes de ciertos grupos étnicos, debe ser corregido. La inteligencia artificial explicable, por tanto, no solo mejora la técnica, sino que también fortalece los principios éticos de la práctica médica.

Conclusión

La inteligencia artificial explicable representa un avance significativo hacia una medicina más transparente, comprensible y humana. En un entorno donde la confianza es esencial y las consecuencias de cada decisión son enormes, no basta con que los algoritmos sean precisos; también deben ser entendibles. La XAI permite que los profesionales médicos mantengan el control y la responsabilidad sobre las decisiones clínicas, apoyándose en la tecnología sin renunciar a su juicio profesional.

A medida que la investigación y la implementación de XAI avancen, es fundamental que se sigan desarrollando herramientas que equilibren rendimiento y claridad. Solo así se podrá garantizar que la inteligencia artificial se convierta en una aliada real de la medicina moderna. La combinación de innovación tecnológica y principios éticos puede transformar positivamente la relación entre pacientes, médicos y sistemas automatizados, construyendo un futuro más justo, seguro y transparente para todos.

Nota recomendada: Conozca nuevos planes de YouTube TV para creadores de contenidos

PORTADA

Gustavo Petro califica de «positiva» la reunión con Trump

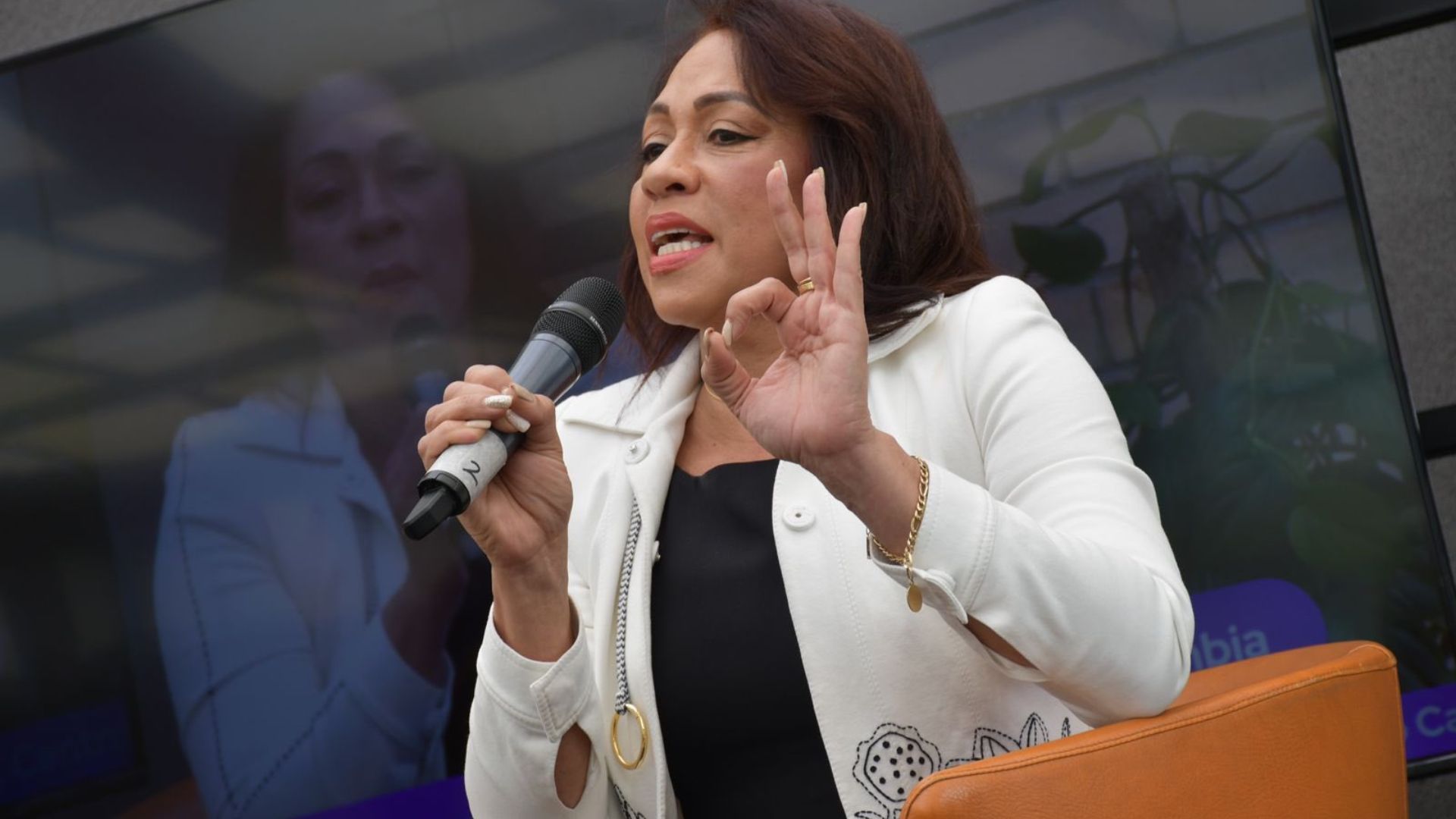

Revocan candidatura de Marelen Castillo

Caso Iván Cepeda queda en manos de conjueces

Los pronósticos en el CNE para Iván Cepeda no le son favorables